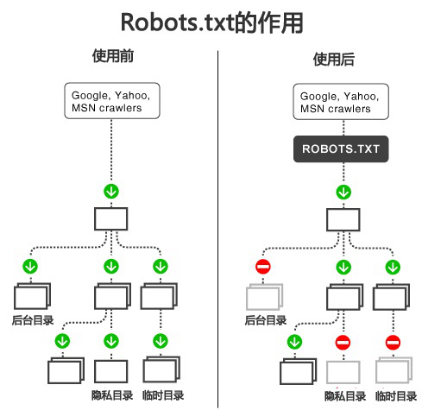

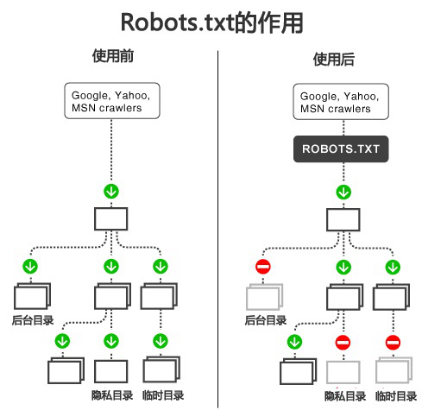

robots.txt是搜索引擎中訪問網站的時候要查看的第一個文件。robots.txt文件告訴蜘蛛程序在服務器上什么文件是可以被查看的。

當一個搜索蜘蛛訪問一個站點時,它會首先檢查該站點根目錄下是否存在robots.txt,如果存在,搜索機器人就會按照該文件中的內容來確定訪問的范圍;如果該文件不存在,所有的搜索蜘蛛將能夠訪問網站上所有沒有被口令保護的頁面。

robots.txt文件特點:必須放置在一個站點的根目錄下,而且文件名必須全部小寫。

robots.txt

文件在SEO中作用:鑒 于網絡安全與隱私的考慮,搜索引擎遵循robots.txt協議。通過根目錄中創建的純文本文件robots.txt,

網站可以聲明不想被robots訪問的部分。每個網站都可以自主控制網站是否愿意被搜索引擎收錄,或者指定搜索引擎只收錄指定的內容。當一個搜索引擎的爬

蟲訪問一個站點時,它會首先檢查該站點根目錄下是否存在robots.txt,如果該文件不存在,那么爬蟲就沿著鏈接抓取,如果存在,爬蟲就會按照該文件

中的內容來確定訪問的范圍。

robots.txt文件的格式:

User-agent: 定義搜索引擎的類型。

Disallow: 定義禁止搜索引擎收錄的地址。

Allow: 定義允許搜索引擎收錄的地址。

格式如:User-agent: * Disallow: /index.html Disallow: /index.php? Disallow: /html/ allow:/search.html

robots.txt文件的寫法:

User-agent: * 這里的“*”代表的所有的搜索引擎種類,“*”是一個通配符。允許所有的搜索引擎來收錄,包括百度、google、yahoo等 。

Disallow: /web/ 這里定義是禁止爬尋web目錄下面的目錄。

Disallow: /dedecms/ 這里定義是禁止爬尋dedecms目錄下面的目錄 。

Disallow: /ppc/ 這里定義是禁止爬尋ppc目錄下面的目錄 。

Disallow: /SEO 是屏蔽A目錄下的所有文件,包括文件和子目錄,還屏蔽 /SEO*.*的文件。

Disallow: /seo-study/*.htm 禁止訪問/seo-study/目錄下的所有以".htm"為后綴的URL(包含子目錄)。

Disallow: /*?* 禁止訪問網站中所有帶“?”的URL。

Disallow: /.jpg$ 禁止抓取網頁所有的.jpg格式的圖片。

Disallow:/dedecms-label/arclist.html 禁止爬取dedecms-label文件夾下面的arclist.html文件。

Allow:/linxige/ 這里定義是允許爬尋linxige目錄下面的目錄。

Allow: /seo 這里定義是允許爬尋seo的整個目錄。

Allow: .htm$ 僅允許訪問以".htm"為后綴的URL。

Allow: .gif$ 允許抓取網頁和gif格式圖片。

常用的搜索引擎類型有: (User-agent區分大小寫)

1.google蜘蛛:Googlebot Google Adsense蜘蛛:Mediapartners-Google 2.百度蜘蛛:Baiduspider 3.360蜘蛛:360Spider

4.yahoo蜘蛛:Yahoo!Slurp 5.alexa蜘蛛:ia_archiver 6.bing蜘蛛:MSNbot 7.Soso蜘蛛:Sosospider, 8.有道蜘蛛:YoudaoBot等

通過robots.txt可以刪除被收錄的內容:

1、當你的網頁已被收錄,但想用robots.txt刪除掉,一般需要1-2個月。

2、結合Google網站管理員工具,你可以馬上刪除被Google收錄的網頁。

3、結合百度的站長平臺,通過這里可以盡快刪除被百度收錄的頁面:http://www.baidu.com/search/badlink_help.html

使用robots.txt應遵循幾個原則:

1、不要屏蔽首頁的后綴,比如:index.php,index.html 等;

2、不要寫太多帶星號的,盡量簡潔一些,我們看百度和Google的robtos.txt帶星號的寫法幾乎沒有,太多帶星號的,就可能存在誤傷;

3、不用什么都屏蔽,某些頁面即使被收錄了也不影響什么的,就建議可以不用屏蔽。

注:搜索引擎遵守robots的相關協議,請注意區分您不想被抓取或收錄的目錄的大小寫,我們會對robots中所寫的文件和您不想被抓取和收錄的目錄做精確匹配,否則robots協議無法生效。